Treści

Jak zwiększyć kontrolę nad procesem produkcyjnym – na przykładzie modernizacji zrealizowanej w firmie Krynica Vitamin

Jak zwiększyć kontrolę nad procesem produkcyjnym – na przykładzie modernizacji zrealizowanej w firmie Krynica Vitamin

Kiedy proces produkcyjny wymaga ciągłej kalibracji w zależności rodzaju od produktów poddawanych obróbce, sprawdza się system automatycznego sterowania. Daje elastyczność, szybkość i większą kontrolę. Wyposażenie w niego działających maszyn jest tańsze niż zakup nowych.

Gdy kupujemy gazowany napój, zwracamy uwagę na kolorowe opakowanie z wyrazistym logo. Pijąc go, koncentrujemy się na smaku i aromacie. Rzadko zastanawiamy się, gdzie został wyprodukowany. Gdybyśmy jednak to robili, doszlibyśmy do wniosku, że bardzo często pite przez nas napoje pochodzą z Krynicy Vitamin – firmy, z siedzibą w Warszawie, będącej wiodącym producentem napojów bezalkoholowych i niskoalkoholowych. Skalę produkcji obrazuje konkretna liczba: 500 milionów.

Właśnie tyle napojów – zarówno w puszkach jak i opakowaniach PET – jest produkowanych rocznie w zakładzie Krynicy Vitamin mieszczącym się w miejscowości Dziadkowskie-Folwark na Podlasiu. Ze względu na wieloletnią współpracę z firmą ASTOR, Eugeniusz Grykowski – główny automatyk firmy – pozwolił nam obejrzeć efekt modernizacji urządzenia służącego do pasteryzacji napojów – pasteryzatora tunelowego.

Analizując ten projekt, pochylimy się nad kwestiami takimi jak: skuteczne zwiększenie kontroli nad procesem produkcyjnym, skuteczna i sprawna odpowiedź na zaburzenia w parametrach środowiskowych, a także elastyczność w sterowaniu i zmianie nastaw produkcji.

Pasteryzacja jest ważną częścią składową procesu produkcji żywności, nie tylko napojów. Dzięki podgrzaniu produktów do określonej temperatury zabijamy bakterie, drożdże i pleśń powodujące przedwczesne psucie się produktów. Proces ten nie pogarsza jednak smaku ani wartości odżywczych. Pasteryzacja pozwala na wydłużenie okresu przydatności do spożycia, a co za tym idzie, na dłuższe przechowywanie produktu i transportowanie go na dłuższym dystansie.

Obraz 1. Obudowa i wnętrze pasteryzatora z produktami, które są pasteryzowane.

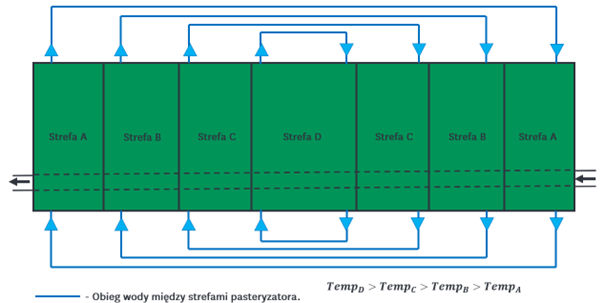

W Krynicy Vitamin proces pasteryzacji realizowany jest w ten sposób, że puszki z napojami na specjalnej taśmie przemieszczają się od strefy do strefy, a w każdej z nich są ogrzewane płaszczem wody o innej temperaturze – początkowo niższej, następnie coraz wyższej (maksymalnie około 68-75 stopni Celsjusza), a na koniec znów niższej. W strefie wysokiej temperatury puszki przebywają około 15 minut. Całość procesu pozwala na zachowanie wydajności na poziomie ponad 50 tys. puszek na godzinę, przy 40-minutowym cyklu pracy.

Obraz. 1 Wnętrze pasteryzatora.

Obraz 2. Podglądowy schemat temperatury w poszczególnych strefach maszyny wraz z obiegiem wody w pasteryzatorze tunelowym.

Przed modernizacją sterowanie procesem odbywało się za pomocą przekaźników i regulatorów temperatury. Wiązało się to z pewnymi ograniczeniami wynikającymi z faktu, że parametry procesu zależne są od kilku zmiennych, takich jak kształt puszki czy rodzaj napoju, który ma być pasteryzowany. Dostosowywanie do tych zmiennych wymagało od operatorów częstego dokonywania ręcznych przezbrojeń i zmiany nastaw.

Taki system sterowania generował duże ograniczenia nadzoru nad procesem. Operator musiał stale monitorować układ, by móc wykrywać ewentualne odchylenia od normy w pracy maszyny i w porę rozpoznać oznaki awarii. To operator zatrzymywał maszynę, gdy widział pierwsze niepokojące sygnały. Ciągłe diagnozowanie układu bywało nużące, bo nie wszystkie niepokojące zjawiska są widoczne na pierwszy rzut oka. Utrzymanie ruchu wymagało więc dokonywania regularnych przeglądów komponentów systemu. Wymagało od operatora dużej czujności i doświadczenia.

„Pierwszy kapitalny remont maszyny przeprowadzono 13 lat temu. Remont przywrócił jedynie pierwotną funkcjonalność urządzenia. Pasteryzator został wyprodukowany w 1992 roku. Zastosowane w nim rozwiązania techniczne znacząco odbiegały od standardów obowiązujących we współczesnych urządzeniach tego typu — zarówno pod względem wydajności, jak i precyzji kontroli parametrów procesu. W celu utrzymania wysokiej jakości produkcji firma przeprowadziła analizę techniczno-ekonomiczną, rozważając dwa warianty: zakup nowego pasteryzatora lub modernizację istniejącego urządzenia. Wyniki analizy wykazały, że modernizacja obecnie używanego modelu jest rozwiązaniem bardziej opłacalnym, zarówno pod względem kosztów inwestycyjnych, jak i integracji z istniejącą infrastrukturą produkcyjną”

– mówi Eugeniusz Grykowski.

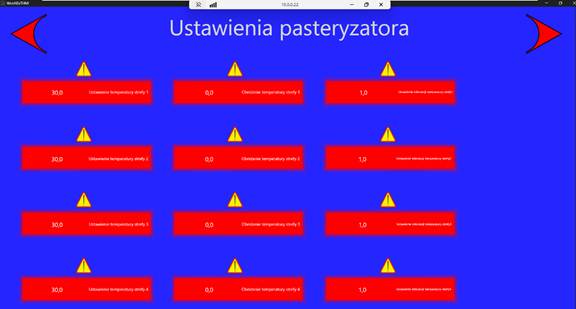

Kompletny remont systemu sterowania został obwarowany kilkoma założeniami. Ustalono, że zmodernizowany system ma pozwalać na:

- dokładny pomiar i kontrole parametrów, wprowadzenie alarmów w razie wystąpienia zaburzenia (za niska temperatura w danej strefie, krótki czas pasteryzacji);

- udostępnianie informacji na zewnątrz do systemu SCADA dla systemów raportowych i laboratorium;

- wizualizację dla operatorów – kontrolę przebiegu procesu pasteryzacji, jak i parametryzowanie produkcji poprzez listę zdefiniowanych receptur;

- kontrolę dostępu do konkretnych funkcji aplikacji realizowaną poprzez tagi RFID.

Spełnienie tych wymogów było możliwe dzięki zastosowaniu kontrolera logicznego CPE210. Moduł ten pozwala na precyzyjne sterowanie pracą napędów i pomp, a także kontrolę temperatury w trakcie procesu pasteryzacji. Pozwala zbierać dane bezpośrednio z warstwy fizycznej. Na łatwość implementacji i konfiguracji nowego systemu sterowania wpłynęło zastosowanie protokołu profinet jako standardu.

O wyborze jednostki i kontrolera z rodziny PACSystems zdecydowała prostota w obsłudze i utrzymaniu – zaletą tej rodziny sterowników jest kompatybilność wsteczna w kontekście środowiska deweloperskiego. Dzięki niej nie ma konieczności utrzymywania różnych wersji oprogramowania narzędziowego dla kontrolerów, które zostały wyprodukowane w różnym czasie. Pozwala to ograniczyć nakłady na zasoby sprzętowe dla automatyków.

Sama wizualizacja wraz z modułem recepturowym oraz synoptykami została stworzona na komputerze panelowym Emerson przy użyciu oprogramowania Movicon. Rozwiązanie to zostało wybrane ze względu na łatwość w tworzeniu projektu, a także szerokie możliwości komunikacyjne – poza standardowymi protokołami przemysłowymi, aplikacja wykorzystuje połączenia do baz danych, co było ważne dla modułu recepturowego. Możliwość prowadzenia bezpiecznej, zdalnej diagnozy awarii i kontroli produkcji, była kolejnym czynnikiem, który przesądził o wyborze rozwiązania.

Modernizacja została przeprowadzona przez wydział automatyki we współpracy z działem utrzymania ruchu i w ocenie Grykowskiego można uznać ją za sukces. Podniosła poziom bezpieczeństwa procesu poprzez kontrole dostępu. Zmniejszyła ilości dokumentów papierowych w obiegu. Pozwoliła wprowadzić dokładny pomiar parametrów pracy, a także umożliwiła udostępnianie danych na potrzeby raportów w sposób autonomiczny. Implementacja pokazuje, że doświadczenie, które idzie w parze ze świadomością możliwości technologicznych, pozwala podjąć takie działania, które nie tylko ułatwiają utrzymanie ruchu, poprawiają bezpieczeństwo, ale i komunikację między różnymi działami w przedsiębiorstwie – pozwalając na osiągnięcie większych korzyści i większej efektywności biznesowej.

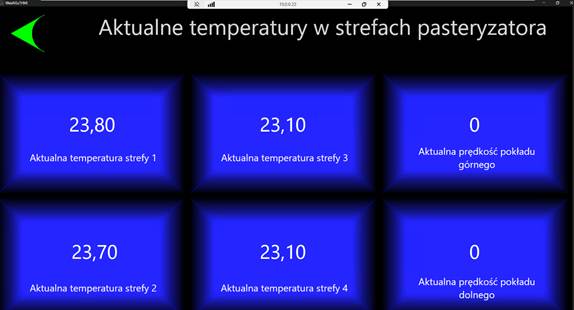

Obraz. 2 Okna synoptyczne dla kontroli i parametryzacji pracy pasteryzatora.